Databroker verhökern die Standortdaten von Millionen Menschen in Frankreich. Neue Recherchen zeigen: Mit den angeblich nur zu Werbezwecken erhobenen Daten lässt sich dort sogar Personal von Geheimdiensten und Militär ausspionieren – inklusive Entourage des französischen Präsidenten.

Diese Recherche entstand in Kooperation mit folgenden Medien: Le Monde (Frankreich), L’Echo (Belgien), Bayerischer Rundfunk. Sie ist Teil der „Databroker Files“.

Ein Name der Person steht nicht im Datensatz. Stattdessen steht dort ein Pseudonym. Eine Kette aus Ziffern und Buchstaben, fast als wäre man einmal mit dem Kopf über die Tastatur gerollt. Und mit diesem Pseudonym versehen sind Hunderte exakte Geo-Koordinaten in Frankreich. Legt man die Geo-Koordinaten auf eine Karte, wird sichtbar, wo die Person überall unterwegs war.

Das Bewegungsprofil verrät mehr, als es ein bloßer Name getan hätte.

So lässt sich etwa ablesen, dass die Person Zugang zum Élysée-Palast hat, dem Amtssitz des französischen Präsidenten. Sie war demnach auch in La Lanterne, einem Jagdschloss in Versailles, wo der derzeitige Amtsinhaber Emmanuel Macron gerne das Wochenende verbringt. Weitere Besuche der Person waren auf dem Militärflugplatz Villacoublay, wo Dienstreisen des Präsidenten mit dem Flugzeug beginnen und enden. Besucht hat die Person auch einen Stützpunkt der Republikanischen Garde, also jenem Polizeiverband, der unter anderem den Präsidenten bewacht.

Sogar eine private Wohnadresse lässt sich in den Daten erkennen. Hier häufen sich die Handy-Ortungen. Ab jetzt ist es leicht, die Person zu identifizieren. Es genügt ein Besuch vor Ort. Und voilà: Auf dem Briefkasten steht der Name eines Menschen, der einer simplen Online-Recherche zufolge für die französische Gendarmerie arbeitet. Ein weiteres online verfügbares Dokument bekräftigt die Verbindung zu Macron.

Um die Identität der Person zu schützen, gehen wir nicht näher auf das Dokument ein. Doch gemeinsam mit unseren Recherchepartnern haben wir zahlreiche weitere brisante Fälle in dem Datensatz gefunden. Sie zeigen erstmalig am Beispiel Frankreichs, dass der unkontrollierte Handel mit Werbe-Daten nicht nur die Privatsphäre von Millionen Menschen gefährdet, sondern auch die Sicherheit Europas.

Ortungen bei Geheimdiensten, Militär und Rüstungskonzernen

Standortdaten wie diese sind wertvolles Material für Spionage, gefundenes Fressen für fremde Geheimdienste. Die Daten stammen nicht aus einem Hack oder einem Leak, sondern von einem Databroker. Um solche Daten zu erhalten, muss man nur freundlich nachfragen – und keinen Cent bezahlen.

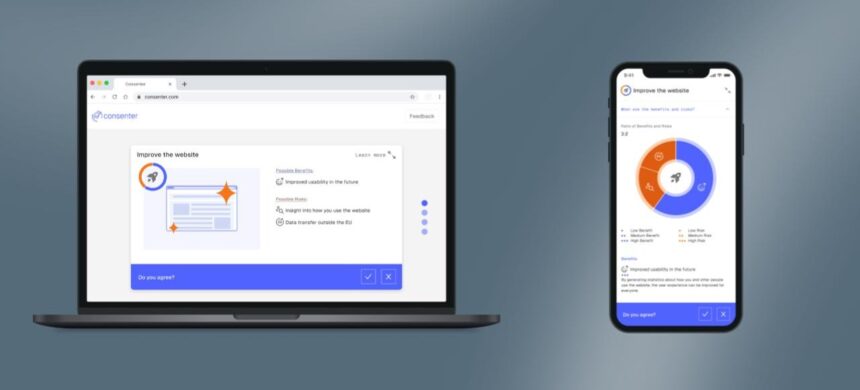

Databroker verkaufen solche Handy-Standortdaten von Millionen Menschen als Abonnement; Vorschau-Daten gibt es gratis. Für jeden Standort im Datensatz gibt es eine einzigartige Kennung, die sogenannte Werbe-ID. Handy-Nutzer*innen bekommen sie automatisch von Google und Apple zugewiesen. Sie ist wie ein Nummernschild fürs Handy und sorgt dafür, dass über Apps ausgeleitete Handy-Standortdaten miteinander verknüpft werden können, bis sie letztlich nicht mehr anonym sind. Allein im Gratis-Datensatz, der dem Recherche-Team vorliegt, stecken rund eine Milliarde Standortdaten von bis zu 16,4 Millionen Geräten in Frankreich.

Andere verdienen ihr Geld mit euren Daten, wir nicht!

Recherchen wie diese sind nur möglich durch eure Unterstützung.

Seit mehreren Monaten recherchiert Le Monde gemeinsam mit netzpolitik.org, Bayerischem Rundfunk und weiteren internationalen Partnern. Es geht um die Massenüberwachung mithilfe von Handy-Standortdaten, die angeblich nur zu Werbezwecken erhoben werden. Die Recherchen aus Frankreich sind der neuste Teil der Databroker Files, die seit Februar 2024 erscheinen.

Zuvor hat das Team etwa über Standortdaten aus Belgien und aus Deutschland berichtet. Andere Medien enthüllten auf eigene Faust ähnliche Missstände in den Niederlanden, Norwegen, Schweden, der Schweiz, Irland und Italien.

All diese Recherchen zeigen: Kein Ort und kein Mensch sind sicher vor dem Standort-Tracking der Werbeindustrie. Um die Gefahr des Trackings anschaulich zu machen, hat sich Le Monde nun auf Handy-Ortungen fokussiert, die für die nationale Sicherheit von Frankreich relevant sind. So konnte das Team in mehreren Dutzend Fällen mit Sicherheit oder hoher Wahrscheinlichkeit Identität, Wohnort und Gewohnheiten von Angestellten sensibler Einrichtungen nachvollziehen. Dazu gehören Angestellte von Geheimdienst und Militär in Frankreich, der Spezialeinheit GIGN, die für Terrorismusbekämpfung zuständig ist, sowie Personal von Rüstungsunternehmen und Kernkraftwerken.

Besuche in der Deutschen Botschaft und beim Polo

Mehrere Bewegungsprofile aus dem französischen Datensatz haben sogar einen Bezug zu Deutschland. So zeigt ein Profil die Bewegungen einer Person, die möglicherweise als Diplomat*in arbeitet. Sie hat Zugang zur Rechts- und Konsularabteilung der deutschen Botschaft und zur Residenz des deutschen Botschafters in Paris. Die Handy-Ortungen zeigen eine Reise nach Verdun, inklusive Besuch von Museum und Gedenkstätten. Auch ein Abstecher zu einem Polofeld in Paris ist zu finden.

Aus dem Auswärtigen Amt heißt es, die Risiken durch Databroker seien bekannt. Die Mitarbeitenden würden regelmäßig zu den Risiken sensibilisiert – müssten aber gleichzeitig umfassend erreichbar sein.

Weitere Bewegungsprofile aus dem Datensatz konnte das Recherche-Team Angestellten von Rüstungsunternehmen zuordnen. Gerade wegen der militärischen Bedrohung durch Russland ist die europäische Rüstungsindustrie besonders dem Risiko von Spionage und Sabotage ausgesetzt. Im Datensatz finden sich etwa die Handy-Ortungen einer Person, die offenbar in hoher Position für den deutsch-französischen Rüstungskonzern KNDS tätig war. Zu den Produkten von KNDS gehören Panzer, Bewaffnungssysteme, Munition und Ausrüstung; das Unternehmen, das durch eine Fusion von Krauss-Maffei Wegmann und Nexter entstand, ist ein wichtiger Lieferant für die Ukraine.

Auf Anfrage teilt der Konzern mit, man sei sich der Notwendigkeit bewusst, Mitarbeitende für diese Themen zu sensibilisieren. Über ergriffene Maßnahmen wolle man jedoch nicht öffentlich sprechen.

Von „Sensibilisierung“ sprechen viele Organisationen, wenn man sie danach fragt, wie sie sich vor der Überwachung schützen wollen. So schreiben etwa die Pressestellen des französischen Verteidigungsministeriums und Inlandsgeheimdiensts DGSI auf Anfrage von Le Monde von der Sensibilisierung ihrer Angestellten. Mit Sensibilisierung – und zwar in Form einer Rundmail – hatten im November auch die Organe der Europäischen Union auf unsere Recherchen reagiert, die zeigten, wie sich mithilfe der Standortdaten Spitzenpersonal der EU in Brüssel ausspionieren lässt.

Das Problem: Sensibilisierung reicht nicht. Um dem Standort-Tracking durch die Online-Werbeindustrie zu entgehen, müssen Nutzer*innen intensiv und lückenlos digitale Selbstverteidigung anwenden, bis hin zum Verzicht auf populäre Online-Dienste. Die vielfältigen Wege, über die Daten abfließen können, sind kaum zu überblicken. Nicht einmal auf Datenschutz-Labels in App-Marktplätzen kann man sich verlassen, wie unsere Recherchen gezeigt haben.

Und so ist es schier unvermeidbar, dass aller Sensibilisierung zum Trotz immer wieder Daten abfließen und in die Hände von Databrokern gelangen – selbst Standortdaten aus der Entourage des französischen Präsidenten.

Eine Gefahr für Europa

Auf Anfrage von Le Monde hat der Élysée-Palast selbst nicht reagiert. Zumindest für Präsident Macron dürfte das Thema jedoch nicht ganz neu sein. Denn im Jahr 2024 hatte Le Monde schon einmal Standortdaten von Menschen aus seinem Umfeld aufgespürt, und zwar über die Fitness-App Strava. Damit können Nutzer*innen etwa ihre Jogging-Routen tracken und online mit der Öffentlichkeit teilen, was Macrons Sicherheitspersonal unvorsichtigerweise getan hatte.

Der Unterschied: Damals ging es um den Umgang mit einer einzelnen Fitness-App. Die Databroker Files zeigen jedoch, wie sensible Handy-Standortdaten über einen großen Teil kommerzieller App abfließen können. Inzwischen liegen dem Recherche-Team mehrere Datensätze von mehreren Databrokern vor. Sie umfassen rund 13 Milliarden Standortdaten aus den meisten Mitgliedstaaten der EU, aus den USA und vielen weiteren Ländern.

Die Databroker Files zeigen auch, dass die DSGVO (Datenschutzgrundverordnung) gescheitert ist – mindestens in ihrer Durchsetzung. Der unkontrollierte Datenhandel bedroht nicht nur auf beispiellose Weise die Privatsphäre und informationelle Selbstbestimmung von Nutzer*innen, sondern in Zeiten erhöhter Spionagegefahr auch die Sicherheit Europas.

Im Zuge unserer Recherchen haben Fachleute aus Politik, Wissenschaft und Zivilgesellschaft wiederholt Konsequenzen gefordert. „Angesichts der aktuellen geopolitischen Lage müssen wir diese Bedrohung sehr ernst nehmen und abstellen“, sagte im November etwa Axel Voss (CDU) von der konservativen Fraktion im EU-Parlament, EVP. Die EU müsse entschieden handeln. „Wir brauchen eine Präzisierung der Nutzung der Standortdaten und somit ein klares Verbot des Handels mit besonders sensiblen Standortdaten für andere Zwecke.“ Weiter brauche es „eine europaweite Registrierungspflicht für Datenhändler und eine konsequente Durchsetzung bestehender Datenschutzregeln“.

EU könnte Datenschutz noch weiter abschwächen

Seine Parlamentskollegin Alexandra Geese von der Fraktion der Grünen/EFA sagte: „Wenn der Großteil der europäischen personenbezogenen Daten unter der Kontrolle von US-Unternehmen und undurchsichtigen Datenbrokern bleibt, wird es deutlich schwieriger, Europa gegen einen russischen Angriff zu verteidigen.“ Sie forderte: „Europa muss die massenhafte Erstellung von Datenprofilen verbieten.“

Statt die Gefahr einzudämmen, hat die EU-Kommission jedoch jüngst mit dem Digitalen Omnibus einen Plan vorgelegt, um den Datenschutz in Europa noch weiter zu schleifen. Konkret sollen demnach manche pseudonymisierten Daten nicht mehr als „personenbezogen“ gelten und deshalb den Schutz durch die DSGVO verlieren. Dabei zeigen die Databroker Files eindrücklich, wie intim und gefährlich die Einblicke durch angeblich pseudonyme Daten sein können.

Der EU stehen kontroverse Verhandlungen bevor. Teilweise oder weitgehende Ablehnung zu den Vorschlägen gab es bereits von den Fraktionen der Sozialdemokraten, Liberalen und Grünen im EU-Parlament. Zudem warnten mehr als 120 zivilgesellschaftliche Organisationen in einem offenen Brief vor dem „größten Rückschritt für digitale Grundrechte in der Geschichte der EU“.

Hier liest du, wie du deinen Standort vor Databrokern schützen kannst. Und hier sind alle unsere Texte zu den Databroker Files.

Die Arbeit von netzpolitik.org finanziert sich zu fast 100% aus den Spenden unserer Leser:innen.

Werde Teil dieser einzigartigen Community und unterstütze auch Du unseren gemeinwohlorientierten, werbe- und trackingfreien Journalismus jetzt mit einer Spende.