Die sächsische Regierung möchte das Polizeigesetz deutlich verschärfen und der Polizei KI-Videoüberwachung, biometrische Internetsuche und staatliches Hacken erlauben. Kritik daran kommt aus Zivilgesellschaft und Opposition. Doch gerade letztere braucht die Regierung, um ihren autoritären Entwurf zum Gesetz zu machen.

Die sächsische Polizei soll in Zukunft möglichst viele neue Befugnisse bekommen. So lautet die kürzestmögliche Zusammenfassung des Entwurfs für das neue Sächsische Polizeivollzugsdienstgesetz, kurz SächsPVDG. Was will der Entwurf konkret? Was sagen Opposition und Zivilgesellschaft? Und warum könnte es ausgerechnet auf das Bündnis Sahra Wagenknecht ankommen?

Anfang Oktober stellte der sächsische Innenminister Armin Schuster (CDU) den Entwurf des SächsPVDG vor. Im Fokus der Berichterstattung stehen seitdem vor allem Drohnen, Taser und die elektronische Fußfessel. Doch der Entwurf sieht auch die Ausweitung und Einführung von weiteren Überwachungsmaßnahmen vor, darunter der Staatstrojaner „Quellen-TKÜ“ (Quellen-Telekommunikationsüberwachung), die automatisierte Kennzeichenerfassung, „KI“-Videoüberwachung, Echtzeit-Gesichtserkennung, der biometrische Datenabgleich und eine automatisierte Datenanalyse von Polizeidaten nach Art von Palantir. Doch mehr zu den einzelnen Punkten weiter unten.

Warum die Uhr für das Gesetzes-Update läuft

Der Hauptgrund für die jetzige Gesetzesnovelle ist ein Urteil des sächsischen Verfassungsgerichtshofs. Die Landtagsabgeordneten aus den Fraktionen der Grünen und Linken hatten gegen die letzte Änderung des Polizeigesetzes erfolgreich geklagt. Der Verfassungsgerichtshof sah einige der neuen Vorschriften als unvereinbar mit der sächsischen Verfassung an, lies sie aber mit Einschränkungen bis zu einer Neuregelung weitergelten. Doch diese Frist läuft am 30. Juni 2026 ab, so steht es in dem Urteil.

Innenminister Schuster betont, aktuell würden insgesamt elf Bundesländer ihre Polizeigesetze überarbeiten. „Bei der Gestaltung der Kompetenzen und Befugnisse bewegen wir uns auf Augenhöhe“, sagte er in einer Pressemitteilung.

Während sich die mitregierende SPD im Landtag zu dem Entwurf eher bedeckt hält, feiert die CDU den Vorstoß. „Dieser Entwurf ist ein Sicherheitsgewinn für Sachsen!“, lässt sich der innenpolitische Sprecher der CDU-Fraktion, Ronny Wähner, in einer Pressemeldung zitieren.

„Chinesische Verhältnisse“ mit „endloser Polizei-Wunschliste“

Grüne und Linke, beide in Sachsen in der Opposition, kritisieren den Gesetzesentwurf mit scharfen Worten. Valentin Lippmann von den Grünen sieht einen massiven Eingriff in die Bürgerrechte. „Insbesondere die KI-gesteuerte Datenanalyse, die Möglichkeit des Abgleichs von Bildern mit öffentlich zugänglichen Quellen im Internet und die umfassende biometrische Videoüberwachung bilden ein Gift der Überwachung“, teilte Lippmann mit. Mit dem Entwurf sei Schuster „näher an der Praxis in China als auf dem Boden unserer Verfassung“.

Rico Gebhardt von der Fraktion Die Linke schreibt auf Anfrage von netzpolitk.org, dass der Gesetzesentwurf auch einige positive Dinge enthalte, etwa Umsetzungen des Gerichtsurteils sowie Maßnahmen zum Schutz vor häuslicher Gewalt. Insgesamt sieht er aber „eine endlose Polizei-Wunschliste“ und einen „rechts-autoritären Entwurf“.

„Überwachungsdruck steht in keinem angemessenen Verhältnis zum Ergebnis“

Auch außerhalb des Landtags hagelt es Kritik. Die sächsische Datenschutzbeauftragte Juliane Hundert nimmt seit Jahren eine Verschärfungsspirale in der Sicherheitsgesetzgebung wahr. „Jede neu geschaffene Maßnahme im Bereich der Gefahrenabwehr erhöht den Überwachungsdruck auf die Bürgerinnen und Bürger allgemein, auch wenn sie nicht straffällig werden, und das kann ich nicht gutheißen“, sagt sie auf eine Anfrage von netzpolitik.org zu dem Entwurf.

„Die zunehmende polizeiliche Erfassung des öffentlichen und virtuellen Raums und der damit einhergehenden Überwachungsdruck scheinen in keinem angemessenen Verhältnis zu den Ergebnissen der Maßnahmen zu stehen.“ Hundert sieht in diesem Kontext vor allem die Maßnahmen kritisch, von denen viele Bürger:innen betroffen sind, etwa die Maßnahmen zur „KI“-Videoüberwachung und zum Filmen in Autos zur Verkehrsüberwachung: „Obwohl sie keinen Anlass dafür gegeben haben und in keiner Weise eine Gefahr für die öffentliche Sicherheit oder Ordnung darstellen, werden ihre Daten polizeilich verarbeitet“, kritisiert Hundert.

Kritik von netzpolitischer Szene bis Fußballfans

Stephanie Henkel, die sich beim Dresdener CCC, aber auch der Piratenpartei sowie den Datenpunks engagiert, sieht es ähnlich wie Hundert, sagt aber: „Man kann kaum sagen, was die schlimmste Anpassung ist.“ Ein Grundproblem sei, dass der Verfassungsgerichtshof in seinem Urteil zu viel durchgewunken habe. Nun gehe das Innenministerium mit diesem Entwurf nochmal deutlich über das Urteil hinaus, so Henkel. „Der jetzige Entwurf stellt unterm Strich einen massiven Ausbau der Überwachung in Sachsen dar, gegen den wir uns als Zivilgesellschaft laut und sichtbar stellen müssen.“

Auch aus der Fußballszene kommt Gegenwind zum Gesetzesentwurf. In einem gemeinsamen Statement schreiben die Fanhilfen von Chemie Leipzig, Dynamo Dresden und dem FSV Zwickau: „Mit diesem vorgelegten Gesetzesentwurf zur Regelung der Befugnisse der sächsischen Polizei begeht der sächsische Innenminister Armin Schuster erneut einen bewussten Verfassungsbruch.“ Anstatt die verfassungsgemäße Ordnung des sächsischen Polizeirechts herzustellen, erweitere man dieses um Dutzende weitere verfassungswidrige Punkte, so ein Fanhilfe-Sprecher.

Besonders kritisch sehen die Fan-Anwält:innen die Kombination der verschiedenen Befugnisse, etwa wenn automatisierte Datenanalysen mit Software von Palantir und neue Formen der Videoüberwachungsauswertung zusammenkämen: „Im Zusammenspiel [von Palantir, Anm. d. Red.] mit der nach Gesetzesentwurf geplanten verdeckten automatisierten Kennzeichenerkennung und dem Einsatz intelligenter Videoüberwachung wäre der gläserne sächsische Bürger dann wohl perfekt.“

Doch wie weit gehen die geplanten Befugnisse wirklich?

Jetzt auch Staatstrojaner für die Prävention

In der Strafverfolgung ist der Staatstrojaner zum Anzapfen der laufenden Telekommunikation schon mehrere Jahre lang erlaubt. Das regelt die bundesweit geltende Strafprozessordnung. In Sachsen gilt seit der letzten Novelle des SächsPVDG, dass die Polizei zur Gefahrenabwehr auch die Kommunikation abhören darf. Nun aber steht das erste Mal explizit im Gesetz, dass die sächsische Polizei dafür auch „in von der betroffenen Person genutzte informationstechnische Systeme“ eingreifen darf. Sie darf also hacken. Darauf hatten sich Union und SPD im sächsischen Koalitionsvertrag geeinigt.

Zu den Voraussetzungen gehört nach dem Entwurf selbstverständlich eine richterliche Anordnung. Zudem ist die Maßnahme nur zulässig, „wenn die Abwehr der Gefahr oder die Verhütung der Straftat auf andere Weise aussichtslos oder wesentlich erschwert wäre“. Laut Entwurf geht es um die Verhinderung bestimmter schwerer Straftaten, die sich gegen den „Bestand oder die Sicherheit des Bundes oder der Länder, Leib, Leben, Gesundheit oder Freiheit einer Person oder für Sachen von besonderem Wert, deren Erhaltung im öffentlichen Interesse geboten ist“ richten.

Dass dabei auch Dritte mitüberwacht werden, ist allerdings kein Hinderungsgrund. Zuletzt hatte etwa die bayerische Polizei das Pressetelefon der Letzten Generation – und damit wenig überraschend auch die Gespräche mit Journalist:innen – abgehört. Zwei Journalisten ziehen deshalb zusammen mit der Gesellschaft für Freiheitsrechte vor das Bundesverfassungsgericht.

Kommt Palantir auch nach Sachsen?

Das neue SächsPVDG ebnet den Weg auch für Palantir oder andere Analyseplattformen. Die Polizei soll „zur Gewinnung neuer Erkenntnisse gespeicherte personenbezogene Daten anlassbezogen automatisiert zusammenführen und mit weiteren nach diesem Gesetz oder anderen Rechtsgrundlagen gespeicherten personenbezogenen Daten automatisiert verknüpfen, aufbereiten und auswerten“ können. Die Polizei darf diese Datenanalyse zur Verhinderung einer langen Liste von Straftaten einsetzen, darunter schwere Straftaten, besonders schwere Straftaten, aber auch „zur Abwehr einer Gefahr für den Bestand oder die Sicherheit des Bundes oder der Länder, Leib, Leben, Gesundheit oder Freiheit einer Person oder für Sachen von besonderem Wert, deren Erhaltung im öffentlichen Interesse geboten ist“.

Dabei soll die Polizei fast alle Daten zusammenführen können, über die sie potenziell verfügt: von Daten aus Polizeidatenbanken wie „Gewalttäter Sport“ über Falldaten bis zu Datensätzen „aus gezielten Abfragen in gesondert geführten staatlichen Registern sowie einzelne gesondert gespeicherte Datensätze aus Internetquellen“. Datenschutzbeauftragte Hundert stellt klar: „Dabei werden tausende Datensätze auch von Personen ausgewertet, die nicht Gegenstand polizeilicher Ermittlungen waren.“ Lediglich Daten aus Wohnraumüberwachung und Online-Durchsuchung sollen laut Entwurf nicht miteinbezogen werden.

Näheres soll eine Verwaltungsvorschrift regeln, die dann auch „Kennzeichnungen“ zur Einhaltung der Zweckbindung sowie ein Rechte- und Rollenkonzept beinhalten soll. Rico Gebhardt von den Linken kritisiert das. „Das Parlament wird dann nicht mehr mitreden können. Auch damit werden wirklich alle roten Linien überschritten.“

Gebhardt sieht in dem Entwurf einen „Blankoscheck“, um sich bei „rechtsstaatlich desinteressierten Tech-Oligarchen“ einzukaufen – auch wenn der Name „Palantir“ im Gesetzentwurf nicht explizit falle. Es gebe keine Vorfestlegung auf Palantir, sagte Innenminister Schuster laut Sächsischer Zeitung. Auch die sächsische SPD hatte sich noch vor ein paar Monaten gegen Palantir ausgesprochen.

Stephanie Henkel ist skeptisch, ob es nicht docch auf Palantir hinausläuft: „Ich wüsste nicht, was sie sonst nehmen.“ Henkel erinnert auch an den bereits existierenden Rahmenvertrag, den Bayern mit Palantir ausgehandelt hat. Aktuell setzen Bayern, Hessen und Nordrhein-Westfalen Palantir-Software ein, in Baden-Württemberg soll die Software ab 2026 zum Einsatz kommen.

Videoüberwachung, jetzt mit „Künstlicher Intelligenz“

Neu im Polizeigesetz ist auch der Paragraf zur „KI“-Videoüberwachung. Die Polizei will damit zum einen von einer Software automatisiert erkennen lassen, wenn sich im Bereich der Kameras eine Straftat anbahnt. Konkret soll die Software Waffen und gefährliche Gegenstände erkennen sowie Bewegungsmuster, „die auf die Begehung einer Straftat hindeuten“. Vorbild ist ein Projekt in Mannheim.

Zum anderen soll eine Software auch Personen nachverfolgen können, deren Bewegungsmuster auffällig waren, sofern ein Polizist das bestätigt. Mit richterlicher Anordnung oder bei Gefahr im Verzug darf die Polizei auch einen Abgleich der gefilmten Gesichter mit den eigenen Auskunfts- und Fahndungssystemen durchführen („Fernidentifizierung“).

Diese Gesichtserkennung ist in Sachsen bisher schon erlaubt, allerdings nur an Orten, die wichtig für die grenzüberschreitende Kriminalität sind. Der neue Entwurf ermöglicht nun die „KI“-Videoüberwachung und Fernidentifizierung an Kriminalitätsschwerpunkten sowie bestimmten Veranstaltungen unter freiem Himmel.

Gesichtserkennung mit Daten aus dem Internet

Ebenfalls künftig erlaubt sein soll der Abgleich mit biometrischen Daten aus dem Internet. Konkret nennt der Gesetzesentwurf Gesichter und Stimmen, die die Polizei zum Zwecke der Gefahrenabwehr abgleichen dürfe. Hier braucht es ebenfalls eine richterliche Anordnung. Außerdem soll die Datenschutzbeauftragte nachträglich informiert werden.

Sollte es dieser Paragraf in das finale Gesetz schaffen, wird er wahrscheinlich ein Fall für die Gerichte. Linken-Politiker Gebhardt hat nach eigener Aussage erhebliche Zweifel, „ob so eine biometrische Rasterfahndung, auf die es ja hinauslaufen würde, überhaupt legal betrieben werden kann – oder ihre Anwendung nicht eher dazu führt, das Gesetz erneut in den verfassungswidrigen Bereich zu steuern“.

Laut einem Gutachten von AlgorithmWatch ist es technisch nicht umsetzbar, frei verfügbare Bilder aus dem Internet für einen Abgleich praktikabel durchsuchbar zu machen, ohne eine Datenbank dieser Bilder zu erstellen. Dies wiederum verbietet die KI-Verordnung der EU. Auf die Anfrage von netzpolitik.org, wie dieser Teil des Entwurfs rechtssicher umgesetzt werden soll, hat das sächsische Innenministerium nicht geantwortet.

Noch mehr Abbau von Datenschutz

Insgesamt bedeutet der Entwurf fast überall einen Rückschritt beim Datenschutz. So ist der Polizei künftig eine Weiterverarbeitung von personenbezogenen Daten auch für Aus- und Fortbildungen erlaubt. Auch zum „KI“-Training dürfen personenbezogene Daten verwendet werden. Das gilt selbst dann, wenn man die Daten nicht anonymisieren oder pseudonymisieren kann.

Zu diesem Zweck darf die Polizei die Daten auch an Dritte weitergeben. Rico Gebhardt befürchtet in diesem Zusammenhang einen Tabubruch: „Das erweckt den bösen Anschein, als wäre das Innenministerium bereit, einen Anbieter mit hochsensiblen Daten der Bürgerinnen und Bürger zu ,bezahlen‘.“

Die bisher dargestellten Neuerungen sind nur eine kleine Auswahl aus dem Entwurf. Künftig soll zudem das automatisierte Scannen von Autokennzeichen auch verdeckt erfolgen können – und das pauschal in allen Orten mit einer Grenznähe von unter dreißig Kilometern sowie an Kriminalitätsschwerpunkten. Das ist etwa die Hälfte der Fläche Sachsens. Die Polizei soll außerdem künftig an bestimmten Kreuzungen auch in Autos filmen dürfen, um zu verhindern, dass Fahrer:innen dort das Handy benutzen. Und Bodycams sollen nun auch in Wohnungen filmen dürfen.

Sächsische Koalition muss erst eine Mehrheit suchen

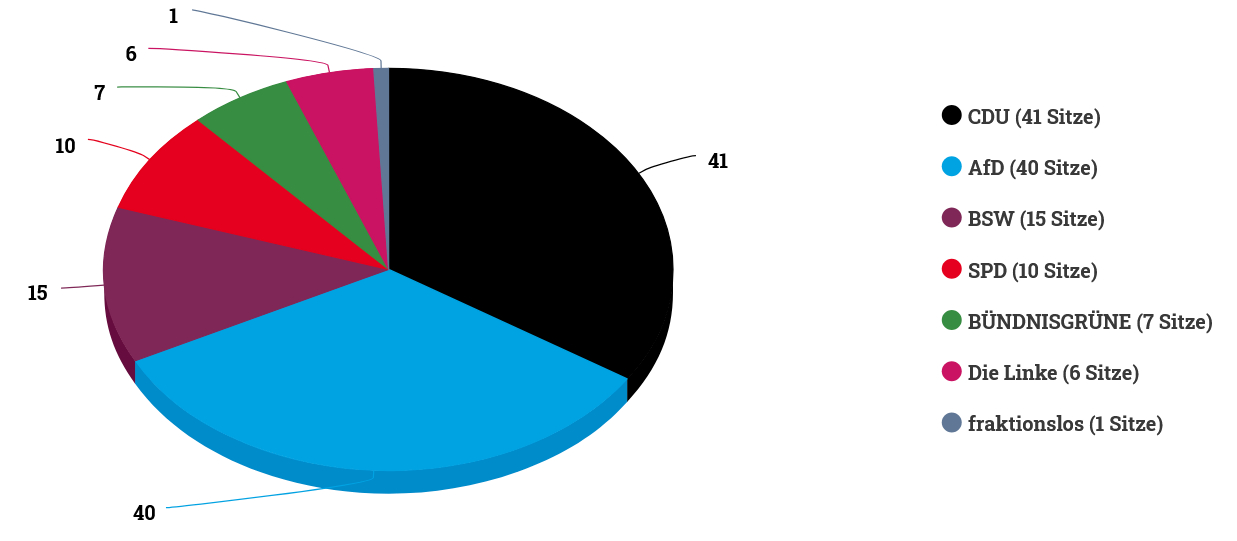

Dass der Gesetzesentwurf in dieser Form überhaupt zum Gesetz wird, ist alles andere als klar. Denn in Sachsen regieren CDU und SPD in einer Minderheitskoalition – also ohne eigene Mehrheit im Parlament. Die Regierung muss also auf die Opposition zugehen, wie zuletzt beim Haushalt, als Grüne und Linke dem Entwurf nach langen Verhandlungen zustimmten.

Das läuft in Sachsen über den sogenannten Konsultationsmechanismus. Nachdem die Regierung einen Entwurf veröffentlicht, können die Fraktionen Stellungnahmen abgeben, ebenso wie Verbände, Kommunen oder Einzelpersonen. Diese Frist läuft für die Zivilgesellschaft noch bis zum 30. Oktober. Laut Rico Gebhardt, haben die Fraktionen bis zum 10. Dezember Zeit, Stellungnahmen abzugeben.

Die Staatsregierung arbeitet dann Änderungsvorschläge ein und stellt den Entwurf schließlich dem Parlament vor. Politisch bedeutet das, dass die Regierung auf Vorschläge der Opposition wird eingehen müssen, wenn sie einen mehrheitsfähigen Entwurf im Landtag einbringen will.

Wer verschafft dem Polizeigesetz die Mehrheit?

Auch wenn beide Fraktionen Stellungnahmen einreichen werden: Grüne und Linke sorgen vermutlich nicht für eine Mehrheit. Beide hatten gegen das aktuelle Gesetz geklagt und positionieren sich auch deutlich gegen die geplante Novelle. So sagt der innenpolitische Sprecher der Grünen, Valentin Lippmann: „Wir Bündnisgrüne werden in unserer Stellungnahme deutlich machen, dass wir für einen solchen freiheitsfeindlichen Gesetzentwurf nicht zur Verfügung stehen.“ Zudem müsste die sächsische Regierung aufgrund der Sitzverteilung sowohl Grüne als auch Linke ins Boot holen, um eine Mehrheit zu erreichen.

Aktivistin Henkel hält es für möglich, dass auch die AfD für die Mehrheit sorgen könnte. „Ich vertraue der CDU nicht. Für die AfD wäre der Entwurf ein Gewinn“, meint Henkel. „Alles was da drin steht, ist für die Gold wert, wenn die einmal an der Macht sind.“ Doch eine Zusammenarbeit mit der AfD würde vermutlich die SPD vor den Kopf stoßen – und den Koalitionsvertrag brechen. Dort heißt es: „Eine Zusammenarbeit oder eine Suche nach parlamentarischen Mehrheiten mit der AfD als gesichert rechtsextrem eingestufter Partei wird es durch die neue Regierung und die Koalitionsfraktionen nicht geben.“

Deshalb rückt das Bündnis Sahra Wagenknecht in den Fokus. Mit seinen 15 Abgeordneten könnte das BSW dem Gesetzesentwurf eine Mehrheit verschaffen. Doch wie sich das BSW positioniert, ist alles andere als klar.

BSW berät sich intern noch

Dem MDR teilte das BSW Anfang des Monats mit: „Die BSW-Fraktion steht für ein modernes Polizeivollzugsdienstgesetz mit dem Stand der Technik entsprechenden Befugnissen. Gleichzeitig treten wir für eine Balance von Freiheit und Sicherheit ein. Deshalb wollen wir den Gesetzesentwurf gründlich prüfen und in der Fraktion beraten.“ Diese fraktionsinterne Abstimmung dauere an, teilte der innenpolitische Sprecher der BSW-Fraktion, Bernd Rudolph, auf Anfrage von netzpolitik.org mit.

Im Programm des BSW zur sächsischen Landtagswahl hieß es zum Thema innere Sicherheit: „Einen übergriffigen Staat lehnen wir ab, weshalb immer die Verhältnismäßigkeit der Mittel und die universelle Unschuldsvermutung gelten müssen. Jedermann soll sich in der Öffentlichkeit frei entfalten können, ohne Angst vor Beobachtung und Überwachung. Mehr Polizisten auf der Straße und in Problemvierteln sind im Bedarfsfall eine größere Hilfe als mehr Videokameras.“

Inwiefern das BSW diese Position in den Verhandlungen durchsetzen kann, werden die nächsten Monate zeigen.

Wie laut wird die Straße sein?

Einige wollen das nicht passiv abwarten. Grünen-Politiker Lippmann rät den Sächs:innen, das Beteiligungsportal zu nutzen und die eigene Meinung zum Gesetz zu hinterlegen. Bis zum 30. Oktober können Bürger:innen und Verbände noch Stellungnahmen einreichen. Auch Henkel ruft dazu auf.

Trotz der vielen Verschärfungen im Gesetz hat Henkel Hoffnung – auch dank der Proteste gegen Palantir und die Chatkontrolle. „Endlich ist mal wieder ein Bewusstsein da, dass Massenüberwachung böse ist.“ Das habe sie noch vor einem Jahr anders erlebt. „Ich hoffe, dass sich jetzt mehr Leute finden, die gegen das neue SächsPVDG in Sachen protestieren werden.“

Die Arbeit von netzpolitik.org finanziert sich zu fast 100% aus den Spenden unserer Leser:innen.

Werde Teil dieser einzigartigen Community und unterstütze auch Du unseren gemeinwohlorientierten, werbe- und trackingfreien Journalismus jetzt mit einer Spende.